Les biais de la publication scientifique

La science n’est pas sans défaut.

La science est à l’heure actuelle la seule démarche dont nous disposons pour produire de la connaissance objective. Pour savoir si un médicament est efficace, pour comprendre de quoi est faite la matière, ce qu’il se passe dans le système solaire, pour vérifier une filiation ou tester la composition d’un produit du commerce, nous nous tournons vers la science.

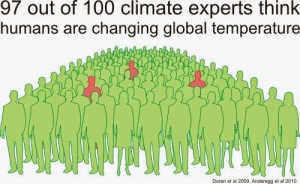

Le consensus scientifique est le plus haut degré de certitude auquel nous pouvons prétendre, en dépit des polémiques et des idéologies. Ce consensus nous permet de savoir que la Terre n’est pas le centre de l’univers, il a relié de manière définitive le virus du VIH avec le sida, il nous permet d’expliquer les arcs en ciel, les tsunamis et les volcans. Bref, le consensus scientifique est l’un de nos outils les plus précieux dans la compréhension du monde.

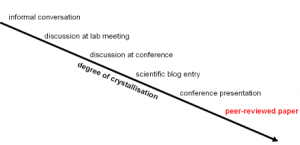

Depuis un siècle et demi, la publication des travaux scientifiques dans les revues professionnelles est le moyen par lequel les experts de chaque domaine partagent des conclusions qui vont être discutées et devenir éventuellement la vérité consensuelle : ce qu’on appelle l’état de l’art. Mais il y a un mais. En tant qu’aventure humaine, la science est émaillée d’imperfections, sa fiabilité n’est pas absolue, certains défauts entachent la confiance que l’on peut placer en elle. Quelle est la gravité de ces défauts ? Quelles sont les solutions, si elles existent ? C’est que nous allons regarder de plus près.

Chaque année se publient des milliers d’articles scientifiques dont les résultats sont souvent fondés sur des calculs statistiques à partir d’observations. Ces résultats étant statistiques, il en résulte inévitablement que quelques-uns des articles qui sortent arrivent à de fausses conclusions. Telle est la limite de la méthode.

Ce n’est pas dramatique parce que sur chaque sujet il se publie un certain nombre d’articles. Plus le sujet est délicat, important ou polémique, plus les études sont nombreuses. Et c’est heureux car quand le nombre d’études augmente, il devient presque impossible que toutes puissent avoir tort. Par conséquent, si toutes les études montrent que l’homéopathie est inefficace, alors cela veut dire qu’il est raisonnable de le penser.

Oui, mais alors… que faire si certaines publications vont à l’encontre du consensus ? À qui faire confiance ? C’est là qu’il est intéressant de se pencher sur les biais de la publication scientifique.

Nous allons donc passer en revue :

1) L’Effet Tiroir

2) Le deuxième Effet Tiroir

3) L’effet Sexy

4) La consanguinité

1) L’effet Tiroir.

Les revues scientifiques ont tendance à accepter de publier plus facilement les études qui contiennent un résultat « positif », qui rejettent l’hypothèse nulle, c’est-à-dire celles qui concluent positivement sur la réalité d’un effet. On le constate dans le domaine des effets biologiques des ondes électromagnétiques : les éditeurs ou les correcteurs jugent plus durement une étude si elle conclut à une absence d’effet.

Le biais à l’œuvre est culturel. Tous autant que nous sommes avons tendance à penser qu’un travail est important et de qualité s’il montre que quelque chose est vrai. Par conséquent, nous avons besoin que les scientifiques attachent autant d’importance aux travaux qui démontrent que quelque chose est faux.

—> Ce biais a pour conséquence que le consensus scientifique aura tendance à surestimer la réalité des effets testés (effets des médicaments, des ondes, de la psyché et autres hypothèses de départ).

Une solution proposée (et déjà en place dans le milieu pharmaceutique) est de déposer un projet de recherche détaillant le protocole AVANT de réaliser les travaux. Ainsi, pourvu que le travail soit accepté par les pairs, il est assuré d’être publié quels que soient les résultats : c’est la garantie d’une meilleure objectivité.

2) Le deuxième Effet Tiroir.

En parfaite connaissance du premier Effet Tiroir, les chercheurs ont tendance à davantage exploiter leurs résultats positifs que leurs résultats non significatifs.

Aujourd’hui, le travail des chercheurs est jugé sur la quantité des articles et sur la qualité des journaux. Certains chercheurs vont préférer s’orienter vers des questions susceptibles d’intéresser les journaux (biais de thématique) et peuvent également préférer s’intéresser à des jeux de données prometteur pour leur hypothèse de départ : les jeux de données qui ont le plus de chance de leur permettre d’avoir un article accepté dans une revue à fort facteur d’impact. Cela risque toujours de se faire au détriment d’un jeu de données plus fidèle à la réalité du phénomène. Une forme d’autocensure frappe les expériences qui ne donnent pas les résultats « espérés ».

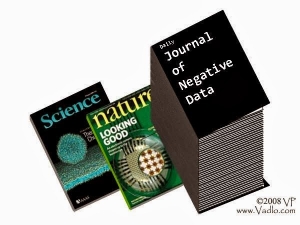

Chez les scientifiques on évoque souvent, sur le ton de la blague, l’idée de créer un jour un Journal des Résultats Négatifs. En l’absence d’un tel journal, beaucoup d’expériences pourtant réalisées restent à l’état de graphes et de tableaux, leurs auteurs ne prenant jamais la peine de rédiger un article peu vendeur. Ces données s’entassent au fond des tiroirs et n’accèdent jamais au rang de la publication scientifique.

Et l’on peut imaginer que, peut-être, tous les laboratoires du monde occupent une partie non négligeable de leur temps et de leurs ressources à conduire des expériences que d’autres ont déjà menées, des expériences dont les résultats décevants n’ont incité personne à les publier.

3) L’Effet Sexy

Les nouvelles idées, pour peu qu’elles soient défendues par des institutions solides ou des chercheurs déjà respectés, sont dites « sexy », elles séduisent les éditeurs. Cet attrait pour la nouveauté a tendance à remettre en question les connaissances établies et les consensus en place. C’est à double tranchant.

C’est une bonne chose, cela permet à ces idées nouvelles de se diffuser et donc d’être soumises à l’examen par les experts et à leurs critiques.

Mais mes journalistes scientifiques et les vulgarisateurs sont souvent particulièrement friands des articles qui semblent chambouler un champ disciplinaire, ce qui donne l’illusion dans leurs comptes-rendus qu’il existe une controverse qui n’est le plus souvent qu’une perturbation passagère dans le champ des idées, ou tout simplement un apport intéressant à un corpus déjà en place.

Par exemple de nouveaux fossiles d’hominidés, quand ils viennent contredire l’arbre phylogénétique de la lignée humaine tel qu’il est compris, ne font pas trembler les fondations de la théorie de l’évolution. Ces fossiles sont un ajout d’information qui contribue à corriger ce qu’on croyait savoir.

4) La consanguinité

Le nombre d’experts dans un domaine particulier n’est pas infini. Sur chaque question pointue ne travaillent qu’un petit nombre d’équipes de par le monde. Il en résulte que certains chercheurs très influents figurent dans la liste des auteurs de la plupart des papiers ayant trait à leur spécialité. Des études qui semblent indépendantes ne le sont pas réellement.

Si un chercheur jouissant d’une telle position utilise son influence pour défendre une idée erronée, cette idée se retrouvera dans une proportion d’articles qui, au final, risque d’apparaître majoritaire dans la communauté scientifique.

Heureusement sur les sujets réellement polémiques et à forte valeur ajoutée, le nombre d’équipes est plus important, et la réplication des travaux est plus systématique, ce qui atténue le risque. Mais sur des sujets moins « chaud », ce biais est peut-être responsable d’un certain nombre de méconnaissances dont nous ne pouvons pas avoir connaissance, par définition.

La puissance salvatrice des méta-analyses.

De plus en plus régulièrement des chercheurs s’adonnent à un travail de recollement des données. Ils rassemblent les résultats des dernières années sur une question bien particulière afin de les comparer et d’en tirer une conclusion générale dans ce qu’on appelle des méta-analyses. Sur des sujets controversés (ne serait-ce que dans l’esprit des non-experts), c’est un bon moyen d’obtenir le fin mot de l’histoire : y a-t-il oui ou non consensus sur telle ou telle question ?

À cette fin il est souvent révélateur de classer les études en fonction de la puissance de leur appareil statistique (qualité du design expérimental, qualité des contrôles, nombre de réplicats, prise en compte des éventuelles interdépendances des données, etc.). Si on observe une nette tendance à obtenir la réponse A du côté des études de haute qualité statistique et la réponse inverse du côté des publications avec des statistiques moins performantes, cela signifie que le consensus A est plutôt de bonne qualité.

Par exemple, c’est ce qu’on obtient avec toutes les méta-analyses qui s’intéressent à l’homéopathie. Les études qui montrent le plus d’effet des produits homéopathiques sont systématiquement celles qui sont les plus fragiles au niveau de leurs statistiques, tandis que les études de bonne qualité sont d’accord entre elles pour dire que l’homéopathie n’a pas d’effet[1].

Le tableau n’est pas si noir, et en dépit des défauts réels que nous avons identifiés, et des risques toujours présents de conflits d’intérêts pour des raisons financières ou politiques, la démarche scientifique demeure notre meilleur moyen d’apprendre comment fonctionne le monde. Nous devons prendre soin de cet outil, l’examiner de près, et ne jamais rechigner à l’améliorer.

Nous n’avons pas, et nous n’aurons sans doute jamais aucune connaissance sur l’univers dont le degré de certitude surpasse celui du consensus scientifique qui est une approche asymptotique de la compréhension du monde. C’est pourquoi, quand vous défendez une idée qui va à l’encontre du consensus scientifique, faites rapidement votre autocritique, car statistiquement : vous avez tort.

—-

[1] http://www.thelancet.com/journals/lancet/article/PIIS0140-6736%2805%2967177-2/abstract

Un article qui aborde une question similaire : http://www.largeur.com/?p=4384

Excellent article. C’est synthétique et très clair, merci beaucoup pour ce travail.

Il me semble qu’il y a une faute d’écriture à un moment « Les études qui montrent le plus d’effet des produits homéopathiques sont systématiques celles qui sont les plus fragiles » je pense que tu voulais écrire « systématiquement ».

Impatient d’en lire plus.

Signalons tout de même qu’il arrive que même des méta-analyses peuvent se planter (ça doit être extrêmement rare) comme en atteste cet article de Slate de mars 2016 « Comment autant de scientifiques ont-ils pu tous se tromper à ce point? » :

http://www.slate.fr/story/115289/psychologie-scientifiques-trompes

Même si on est dans le domaine de la psychologie, ça reste tout de même inquiétant…

Vous faites vraiment du beau travail

Félicitations

Très belle article, merci !

J’ai juste une petite critique à faire, mais vous pouviez difficilement le deviner :

« »

Nous n’avons pas, et nous n’aurons sans doute jamais aucune connaissance sur l’univers dont le degré de certitude surpasse celui du consensus scientifique qui est une approche asymptotique de la compréhension du monde. C’est pourquoi, quand vous défendez une idée qui va à l’encontre du consensus scientifique, faites rapidement votre autocritique, car statistiquement : vous avez tort.

« »

C’est faux, il peut y avoir bien mieux que les méthodes scientifiques actuelle :

http://www.intelligence-complexite.org/fr/qui-sommes-nous/lassociation-pour-la-pensee-complexe.html

Ce genre de personne ( les HPI-C ) ont une pensée complexe et donc totalement adapté à la méthode complexe décrite dans le 1er lien ci-dessus.

https://vivreavecsadouance.wordpress.com/2017/05/07/neurosciences-complexe-ou-laminaire/

Au passage, je suis HPI-C. Et j’ai vite compris que les autres ne peuvent pas comprendre la méthode complexe aussi bien que je la comprend. Parce que la différence c’est que moi je le vis cérébralement.