Les pseudosciences ont-elles gagné sur Internet ?

Cet article est rédigé à partir de la conférence du même nom que j’ai présentée à l’occasion des 50 ans de l’AFIS le 9 novembre 2018.

Internet n’existe pas hors du temps et de l’espace, dans un non-lieu où des énergies insoupçonnées produiraient des phénomènes nouveaux. Ce qui se passe sur Internet dépend de ce qu’il se passe ailleurs, et en particulier dans l’organe avec lequel nous l’utilisons : notre cerveau.

Le cerveau n’est pas un organe créé pour philosopher ou faire des maths, la logique pure n’est pas son atout premier, mais il est certaines choses qu’il fait très bien. Le problème est que nous ne savons pas toujours reconnaître les points forts dont nous disposons… ni nos points faibles.

Le cerveau humain est un champion de l’inférence : il imagine très vite des explications sur la base de ce qu’il sait ou croit savoir, ou de ce qu’il désire. Il est surtout très fort pour confirmer ses inférences, pour nourrir des narratifs à l’aide de tous les éléments de son environnement (c’est le biais de confirmation). Ces narratifs impliquent souvent des éléments de théorie de l’esprit : le cerveau cherche à tenir compte des intentionnalités externes. Le singe super-social que nous sommes est le résultat d’une histoire où les principales ressources de notre environnement sont nos semblables ; des autres Homo sapiens dépendent notre survie et notre reproduction, tandis que le principal danger de notre environnement, eh bien c’est aussi les autres Homo sapiens. On répète depuis longtemps que l’Homme est un Loup pour l’Homme. Savoir lire les intentions d’autrui, anticiper les comportements est donc crucial, et ceux qui échouaient trop n’ont pas laissé de descendance.

Décrypter les intentions d’autrui, cela passe le plus souvent, pour notre cerveau, par le prisme des émotions : nous savons lire (et exprimer) des dizaines d’émotions nuancées. Ce en quoi le cerveau humain surpasse tous les autres, ce qu’il fait Vite, Bien et Sans Effort, c’est « construire une histoire cohérente avec l’ensemble des choses que nous tenons pour vraies et qui va confirmer toutes nos intuitions ». Aucune intelligence artificielle à ce jour n’est capable de l’ombre de la moitié de l’esquisse de ce talent. Notre point fort n’est donc pas, dans un premier temps, la réflexion rationnelle.

Belief shoots first

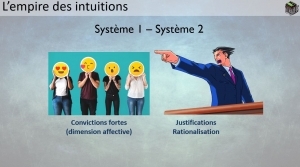

En résumé, nous commençons par croire, et ensuite nous cherchons des raisons de justifier nos croyances. Pour le chercheur en psychologie Daniel Kahnemann, cela s’explique par l’existence de deux « systèmes » dans notre cerveau. Le système 1 est rapide, toujours à l’affût, il saute sur toutes les anomalies ou tous les schémas qui offrent de quoi construire une narration. Le système 2 est plus lent, coûteux, il analyse, il raisonne.

Mais le système 2 est-il lui-même objectif ? Peut-on le comparer à un scientifique rationnel qui évalue prudemment la vraisemblance des propositions ? En réalité, il est souvent au service du système 1 comme un avocat au service de son client : il cherche à valider les conclusions, à donner de la cohérence à ses cognitions. Il est un artisan besogneux du biais de confirmation, et un humain peut être très intelligent, posséder un système 2 extraordinairement efficace et malgré tout persister dans des croyances fausses, car son intelligence lui fournit de grandes quantités d’arguments donnant un semblant de validité à sa vision du monde. Bon gré mal gré, nous confondons « vrai » et « facilement justifiable à l’aide d’arguments qui me viennent à l’esprit ».

Ce qui façonne nos représentations, ce sont d’abord des intuitions, qui possèdent une forte dimension affective (attraction, répulsion). Ensuite, nous cherchons à nous expliquer à nous-mêmes pourquoi nous avons raison d’avoir un tel jugement (c’est la rationalisation). Et nous sommes toujours tentés de nous croire… cela veut-il dire que nous sommes condamnés à l’irrationalité ?

Le remède aux croyances fausses tient dans le bon usage d’un outil simple : l’inhibition cognitive. Il s’agit tout simplement d’un « frein mental ». Il permet de prendre le temps de questionner une idée, une inférence, une opinion, avant de l’incorporer à notre vision du monde. Pour aller vers plus de rationalité, nous devons avoir un recours conscient et méthodique à ce frein, un outil d’autant plus vital que votre bolide est puissant : les personnes très intelligentes, si elles ne savent pas freiner, peuvent finir par croire des choses complexes, baroques, complètement fausses, voire dangereuses non pas malgré mais en raison même de leur intelligence.

Le grand accélérateur des inférences

Internet offre un flux continu de produits cognitifs. Les propositions sont crédibles ou invraisemblables en vertu non pas de leur qualités propres, mais de la manière dont nous les rencontrons : notre disposition personnelle, notre paysage cognitif, le contexte de l’information. « Il n’y a pas de force intrinsèque de l’idée vraie. » disait Spinoza.

On trouve déjà une belle quantité de bullshit dans les médias audiovisuels (y compris dans le précieux service public), dans la presse quotidienne ou les magasines, sous forme de conférences pseudo-savantes et jusque dans les cabinets des médecins et les amphithéâtres des universités… Internet n’est donc coupable que d’une amplification du problème.

Avec Internet, les occasions de croiser une idée qui retiendra notre attention et nous donnera envie d’y croire sont plus grandes que jamais. Mais il y a plus : on y croise une infinité de confirmations à ce que l’on croit déjà, surtout si l’on poursuit une recherche active d’informations dans la zone d’Internet la plus encline à soulager notre besoin de validation.

À ce titre, Internet est le piège ultime des biais de confirmation : recherche motivée, interprétation biaisée, mémorisation biaisée. Internet nous offre en permanence mille-et-un arguments (parfois pourris) auxquels nous raccrocher. Il est le grand accélérateur de nos inférences. La déconversion des croyances bizarres ou extrêmes a peu de chance de se réaliser spontanément dans cet environnement en raison d’une forme d’assuétude à la croyance : notre cerveau nous « récompense » quand nous trouvons un argument pour continuer de croire ce que nous croyions déjà, au lieu de devoir déployer des ressources pour changer d’avis. Nous éprouvons un plaisir mental, le signal interne que nous maîtrisons ce qui nous arrive.

À cela s’ajoute la dimension sociale : nous ne croyons généralement pas seul dans notre coin, mais cherchons la validation de nos idées chez les autres, des gens qui nous ressemblent et envers qui nous pouvons développer une forme d’identification. C’est le phénomène de la bulle de filtre qui crée un cocon nous abritant contre les réfutations, un lieu où trouver des réponses aux informations contradictoires. La pensée de groupe devient alors un puissant levier pour renforcer la croyance et orienter toujours plus l’utilisation d’Internet à l’avantage des idées séduisantes. À cause de cela, chaque débat houleux peut aisément renforcer une croyance : c’est le phénomène de réactance.

Cette grosse machine est un accélérateur de particules. Internet c’est pareil, mais en très différent.

Fausse symétrie

L’intuition tire en premier, elle vise souvent juste, mais confond le sentiment d’être dans le vrai avec une véritable méthode de validation de ses résultats. Donc quand elle se plante, elle n’en a strictement aucune idée.

Si par malheur nous croyons une fake news, et que nous l’incorporons à notre représentation du monde, recevoir une rectification, une « vraie news », n’est pas suffisant pour revenir à l’état initial. Même si nous acceptons de nous défaire du fait incorrect… ce qui est parfois une gageure en vertu du principe d’asymétrie de Brandolini, nous conserverons sans doute l’empreinte de la fake news.

Principe d’asymétrie de Brandolini : « La quantité d’énergie nécessaire pour réfuter du baratin est beaucoup plus importante que celle requise pour le produire. »

C’est se battre contre des moulins à vent que d’espérer opérer une « réinformation » du public ou une chasse systématique du faux. Les contenus frelatés naissent à une cadence infernale, ils séduiront toujours plus qu’une réalité désenchantante, ils nourriront des narratifs idéologiques et leurs puissantes caisses de résonnance, et jamais aucune censure ne sera en mesure de les stopper sans détruire dans le même mouvement la liberté d’expression, ce qui serait un funeste calcul.

Donc c’est perdu ?

Les pseudo-sciences ne sont qu’une manifestation du problème des balivernes en tous genres qui pullulent et prospèrent autour de nous. Les balivernes sont pleinement armées pour rafler la mise sur les réseaux : panique anti-vaccination, anti-glyphosate, fausses médecines, propagandes diverses et variées, extrémismes religieux, climato-négationnisme, idéations conspirationnistes…

À la question de savoir si les pseudo-sciences, les discours faux mais séduisants, les narratifs trompeurs, vont gagner sur Internet, la réponse est oui, évidemment, si nous ne réagissons pas !

Une illusoire régulation d’Internet par le pouvoir politique serait impuissante à contrecarrer leur progression dans les esprits ; la censure n’est pas l’amie de la libre pensée. La vraie réponse ne peut qu’être systémique et pédagogique : réinjecter de la méthodologie, une éducation aux médias, valoriser le bon usage du doute, l’épistémologie, la culture du débat qui implique le respect de la diversité d’opinion, la liberté d’expression, le pouvoir d’investigation d’une presse indépendante, l’alphabétisation scientifique des citoyens et l’exemplarité des personnels politiques et médiatiques.

La tâche est énorme, elle devra compter avec une inertie colossale, et il faudra prendre soin d’évaluer les méthodes employées pour y parvenir. Nous avons donc besoin de travaux de recherche sur l’esprit critique, ce qu’il recouvre et comment on peut éventuellement l’enseigner efficacement.

La réponse aux produits cognitifs avariés la mieux adaptée doit sans doute prendre la forme d’un entraînement à la détection des rhétoriques moisies et des épistémologies faisandées ; l’acquisition d’une meilleure immunité épistémique individuelle pourrait réduire considérablement la diffusion des idées trompeuses qui se répandent comme des virus. Déléguer à une instance le rôle de trier le vrai du faux reviendrait à établir en quelque sorte une « vérité officielle » qui ne serait jamais vraiment indépendante des opinions de ceux qui la pilotent. L’autorité de la chose vraie doit tenir à la méthode employée pour la mettre à l’épreuve et pas à l’institution qui en est l’émettrice. Par conséquent, c’est à chaque citoyen, chaque citoyenne, de s’équiper des moyens permettant d’évaluer la fiabilité des informations et d’accéder à une indépendance intellectuelle jamais pleinement acquise, toujours en construction.

Nous n’avons pas de réelle alternative humaniste et démocratique. Jusqu’à preuve du contraire.

Le problème de cet article est qu’il vient pleinement confirmé ma pensée. Maintenant, il m’est difficile de savoir si je suis ici victime des biais que l’article dénonce. Si je suis conforté en lisant « la menace théoriste » qu’il est important de promouvoir le double aveugle face à l’obscurantisme, le raisonnement face aux intuitions, la réflexion face aux dogmes, c’est peut-être parce que cela va dans le sens de mon schéma mental, pas parce que c’est effectivement ce qui est le plus pertinent de faire…

A ma connaissance, appliquer le doute à la méthode scientifique, revient à pratiquer la « méthode hypercritique », qui n’est pas mieux que l’idée préconçue…

Il y a une vidéo sur la TeB (TeB, sans « u » entre le « e » et le « b »).

Eh bien non, il y a des nuances. La « méthode hypercritique » consiste à s’autoriser à douter de toute réponse déplaisante au prétexte qu’il ne peut y avoir aucune vérité absolu indiscutable. La méthode scientifique consiste à se fier à la meilleure explication disponible, même quand elle n’est pas sympa.

Oups… Je ferais mieux de revoir mes classiques; ça fait trop longtemps que j’ai vu la vidéo, et ce que j’en ai retenu n’est visiblement le message que j’aurais dû.

Mea culpa.

Alors, y-a-t-il un nom au doute excessif, celui qui fait douter de la méthode-même (« scientifique ») de vérification des connaissances?

Je dirais que c’est le propre de la méthode scientifique : douter de tout, y compris de la méthode employée mais, à défaut de meilleure solution, s’en tenir à celle proposée.

Si tu ne t’interrogeais pas sur la méthode elle-même tu ne ferais que du « scientisme » et appliquera is une méthodologie guère plus pertinente que la simple croyance.

Il me semble.

Bien vu ! La confirmation s’applique à tout type de pensée…Elle est d’autant plus flagrante et claire que la pensée se développe et prend de l’élan sans être contredite par une pensée interférente.

Ce que tu décris comme l’inhibition cognitive me fait penser à l’exercice basique de méditation (concentration) : pendant 10 minutes je me concentre et si une idée ou émotion me traverse, je l’examine brièvement et la laisse repartir. Et répéter cet exercice muscle fortement l’inibition cognitive.

Après il y a d’autres exo plus profond et cérébraux sur l’origine des émotions mais si t’as pas la base ça sert à rien.

Ah vivement les cours de méditation de vled et mendax pour mieux penser critique !

Je serais moins optimiste que le dernier paragraphe: la lutte contre les fake news est une cause perdue.

Une raison simple à cela: l’adhésion aux thèses conspirationnistes, ou apparentées, est irréversible, car les enjeux que ça implique rendent la dissonance cognitive d’autant plus forte, voire indestructible. Il suffit de voir les réactions que suscitent les démonstrations irréfutables qu’une photo prise pour authentique est un photomontage ou sortie de son contexte. Loin de remettre en question ce qu’ils pensent de cette photo, les gens se rangeront derrière l’argument que «c’est un faux, mais ça illustre une réalité».

Quand à l’enseignement de la pensée critique, je n’y crois pas non plus. Le monde politique a tout intérêt à ce que nous restions biaisés afin de nous manipuler plus facilement. Et quand bien même ils essayeraient, le système éducatif est déjà dans le collimateur des complotistes, qui l’estiment comme étant juge et partie.

Donc à la question de savoir si ils ont gagné, la réponse est oui.

Sur l’enseignement de la pensée critique freiné par les politiques. Je trouve ce genre de réflexion réductrice, c’est une intution fragile. C’est donner une intention trop précise a un ensemble trop vague. Je pense pas que les politiques français on intérêt a abrutire les français par privatisation d’éducation, je pense que c’est le contraire, l’éducation, former de bon technicien a un enjeux économiques majeure. Par contre les politiciens on bien intérêt a promouvoir le nationalisme. Je pense pas que l’adhésion dd’un pays a son gouvernement ne se fait pas par des stratégies inhibitrices machiavélique.

Ne prêtons pas trop rapidement des intentions au gouvernement.

Cependant, reconnaissons qu’armer les citoyens à avoir plus d’esprit critique, à être capable de ne pas se laisser embobiner en menant des politiques éducatives en ce sens, peut être gênant pour les pouvoirs en place et pour les entreprises. Dans un monde « idéal », les publicitaires et les communicants du gouvernement auraient du souci à se faire.

Je suis assez pessimiste moi-même, mais pas à ce point-là. Surtout, je ne peux être d’accord avec vous sur le caractère irréversible de l’adhésion aux thèses conspirationnistes: ma propre expérience m’a prouvé le contraire. Par ailleurs, si vous fouillez un peu parmi tous les acteurs du monde critique/zététique, vous verrez que c’est un phénomène assez courant. Vous pouvez d’ailleurs en avoir un aperçu dans le documentaire « Les lois de l’Attraction Mentale ».

En quoi elle consiste, votre «propre expérience» ? Ça m’intéresse.

Eh bien, j’étais sûr qu’on nous cachait des choses. Par exemple, j’imaginais volontiers, vers la fin de mon adolescence, que les OVNI (au sens E.T. du terme) existaient, que les gouvernements le savaient et classaient ça en « Top Secret ». Que c’était peut-être eux qui faisaient les crop-circles, ou agroglyphes.

J’étais convaincu également que le 11 septembre était un coup monté.

Je croyais dur comme fer à ce que racontait Jean-Pierre Petit.

Et de tout ça, je suis revenu! 😉

Qu’est-ce qui vous a détrompé, justement ?

D’abord une réflexion menée en mon fort intérieur en parallèle à l’acquisition de nouvelles connaissances au lycée et surtout à l’université. Ensuite des rencontres, des discussions et des documenteurs bien trop gros pour être avalés ont alimenté mon raisonnement. Je me suis dit « si là je suis capable de voir que c’est de la merde, à quel point se fout-on de notre gueule sur les sujets où je n’ai aucune expertise? » Enfin, alors que j’étais déjà dans le doute sur plusieurs points, le dernier clou du cercueil: j’ai pris contact avec la zététique à travers la TeB (le live sur les pyramides, l’univers et le reste). Depuis, j’ai tendance à me ranger du côté des arguments qui me semblent les plus rationnels.

Stema écrit : « Le monde politique a tout intérêt à ce que nous restions biaisés afin de nous manipuler plus facilement. Et quand bien même ils essayeraient, le système éducatif est déjà dans le collimateur des complotistes, qui l’estiment comme étant juge et partie. »

J’interprète cette proposition comme proche des théories de complot… Bien entendu, avec certains dirigeants élus récemment outre-Atlantique on est en droit d’y adhérer. Mais il me semble qu’une attitude scientifique implique de se détacher de toute vision aussi bien pessimiste qu’optimiste ; autrement dit pratiquer l’autocritique avec autant de rigueur que celle de notre analyse des faits sociaux.

Dans l’ensemble, je trouve cet article très utile et très clair !